Em 12 de fevereiro de 2026, a Xiaomi lançou oficialmente seu primeiro modelo de VLA (Visão-Linguagem-Ação) robótico de código aberto, chamado “Xiaomi-Robotics-0”. Com 4,7 bilhões de parâmetros, esse modelo combina a compreensão da linguagem visual com recursos de execução em tempo real de alto desempenho, estabelecendo novos recordes de SOTA (estado da arte) em vários benchmarks.

Aqui estão os principais recursos técnicos e capacidades do modelo:

Arquitetura: Colaboração entre o cérebro e o cerebelo

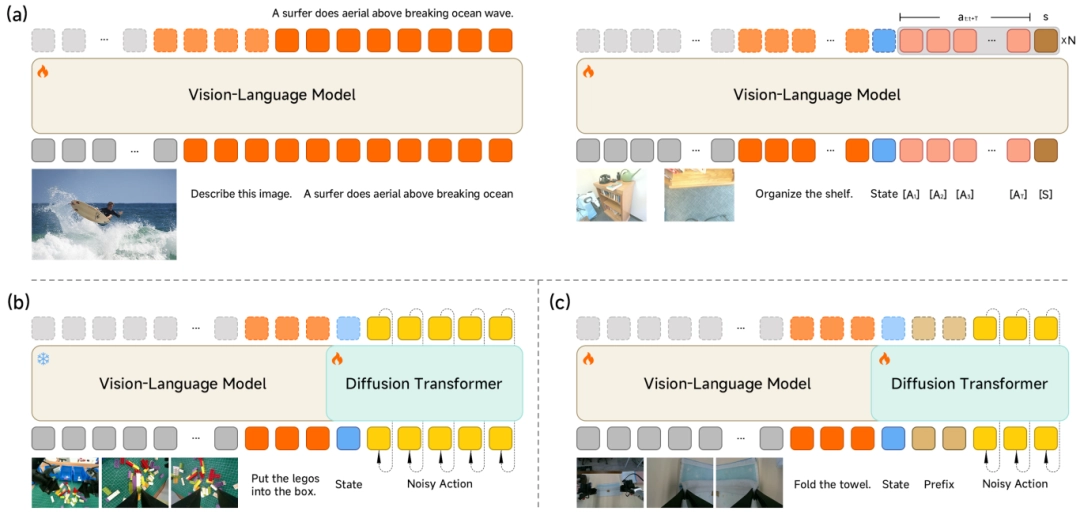

Para equilibrar a compreensão geral com o controle preciso, o Xiaomi-Robotics-0 utiliza uma arquitetura “Mixture-of-Transformers” (MoT).

-

Cérebro de linguagem visual (VLM): Construído em uma base VLM multimodal, é responsável pela compreensão de comandos humanos vagos (por exemplo, “por favor, dobre a toalha”) e pela captura de relações espaciais a partir de entradas visuais de alta definição.

-

Cerebelo de execução de ações (especialista em ações): Para gerar movimentos suaves e de alta frequência, um transformador de difusão (DiT) de várias camadas é incorporado. Em vez de emitir uma única ação, ele gera um “Action Chunk” e garante a precisão usando a tecnologia de correspondência de fluxo.

Estratégia de treinamento: Prevenindo a “redução da capacidade de aprendizagem”

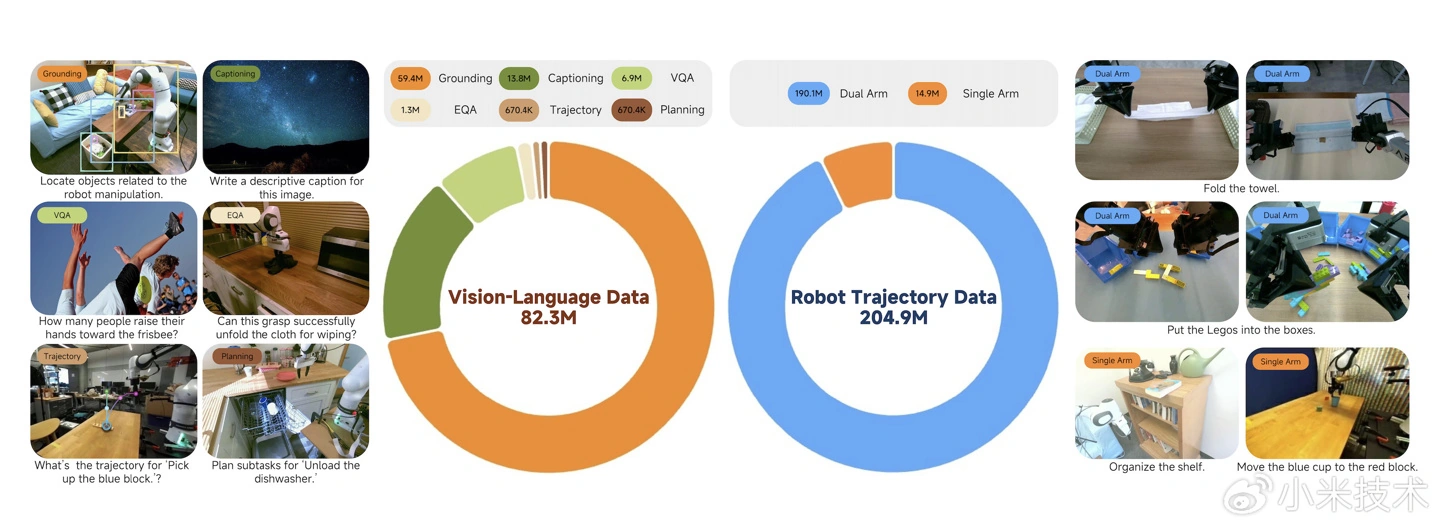

Muitos modelos de VLA tendem a perder suas capacidades de compreensão geral ao aprender ações. A Xiaomi resolve isso com um método de treinamento híbrido que combina dados multimodais com dados de ações:

-

Treinamento sinérgico de VLM: Um mecanismo de “Proposta de ação” força o VLM a prever distribuições de ação enquanto entende as imagens, alinhando o espaço de recursos do VLM com o espaço de ação.

-

Treinamento especializado em DiT: O VLM é congelado e o DiT é treinado para recuperar sequências de ação precisas a partir do ruído, confiando inteiramente nos recursos KV para a geração condicional.

Movimentos fluidos e em tempo real

Para resolver a “gagueira de ação” causada pela latência de inferência em robôs reais, a equipe introduziu técnicas inovadoras:

-

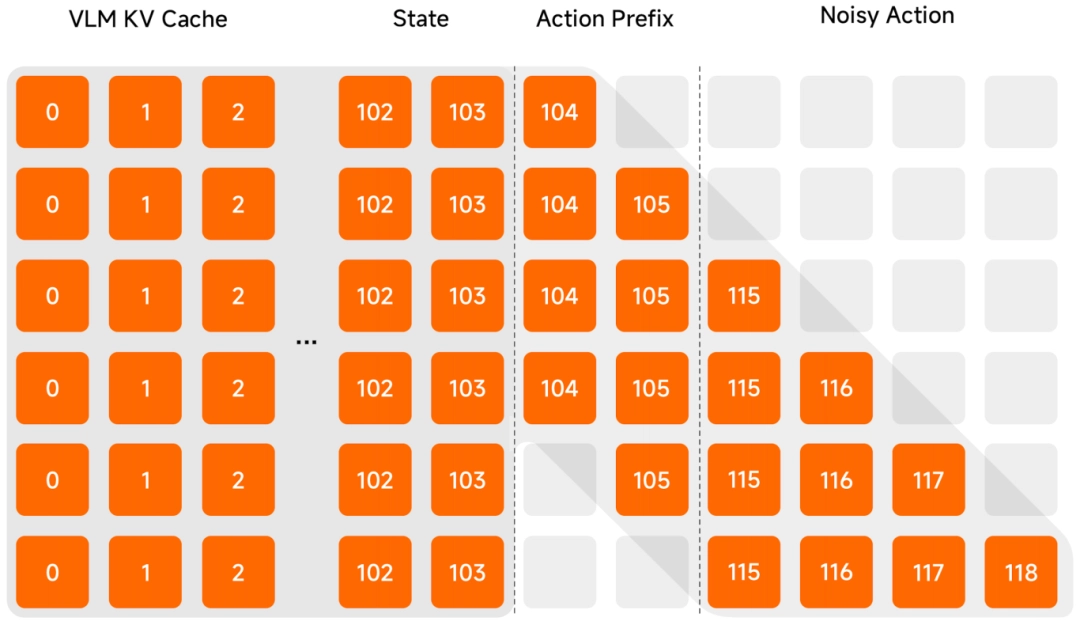

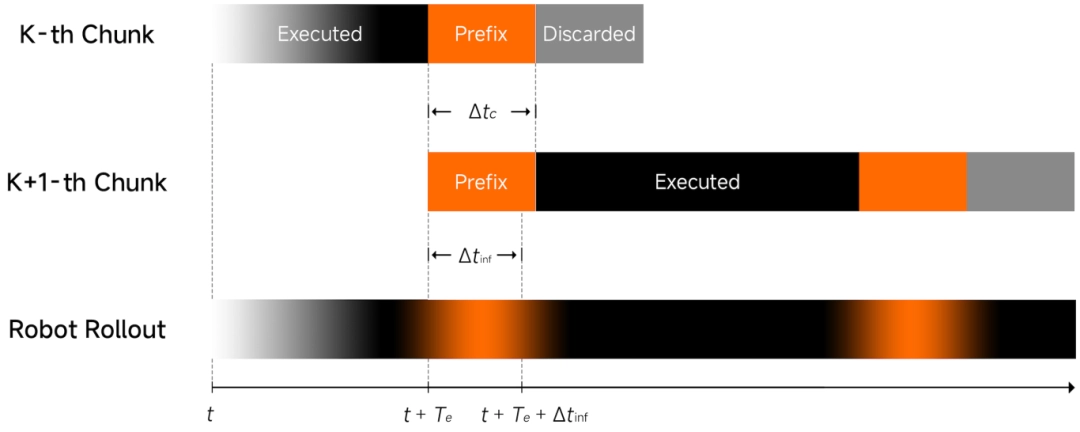

Inferência assíncrona: Desacopla o processo de raciocínio do modelo da execução do robô, permitindo que eles sejam executados de forma assíncrona para uma operação mais suave.

-

Prefixo de ação limpa: Usa a ação prevista anteriormente como entrada para garantir a continuidade da trajetória e reduzir a instabilidade.

-

Máscara de atenção em forma de $\Lambda$: Uma máscara de atenção especial força o modelo a se concentrar no feedback visual atual em vez da inércia histórica, tornando o robô altamente responsivo a mudanças ambientais repentinas.

Desempenho e disponibilidade

-

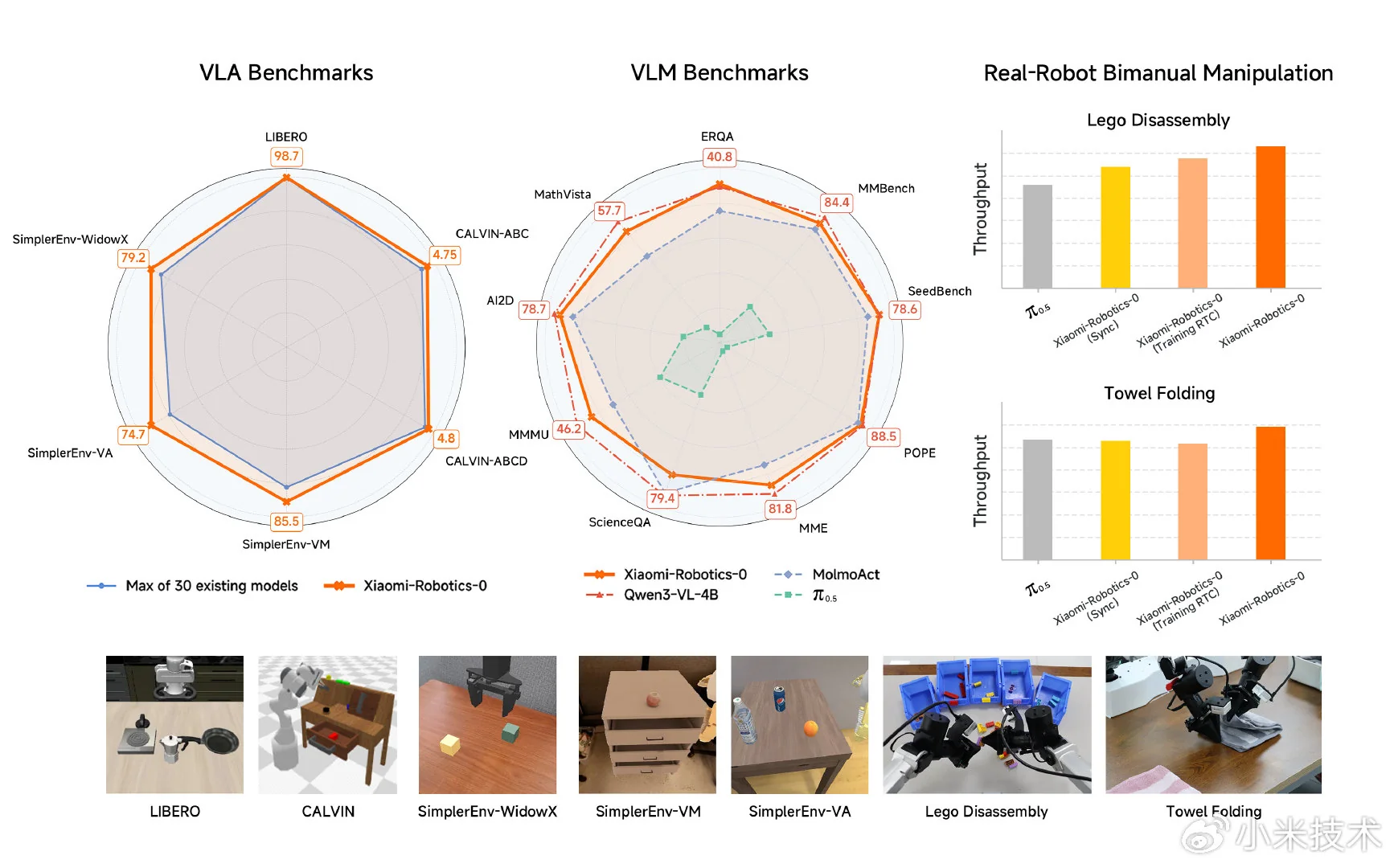

Líder em benchmark: O modelo obteve os melhores resultados entre 30 modelos em benchmarks de simulação como LIBERO, CALVIN e SimplerEnv.

-

Desafios do mundo real: Em testes com robôs de braço duplo, ele demonstrou uma coordenação mão-olho superior em tarefas de longo alcance, como desmontar blocos e dobrar toalhas macias.

-

Compatibilidade de hardware: Oferece suporte à inferência em tempo real em placas de vídeo de nível de consumidor.

A Xiaomi disponibilizou ao público a página do projeto, o código-fonte e os pesos dos modelos:

- Página do projeto: https://xiaomi-robotics-0.github.io

- Código: https://github.com/XiaomiRobotics/Xiaomi-Robotics-0

- Pesos do modelo: https://huggingface.co/XiaomiRobotics

Emir Bardakçı

Emir Bardakçı